You are looking for information, articles, knowledge about the topic nail salons open on sunday near me 크롤링 프로그램 on Google, you do not find the information you need! Here are the best content compiled and compiled by the https://toplist.charoenmotorcycles.com team, along with other related topics such as: 크롤링 프로그램 파이썬 크롤링 프로그램, 무료 크롤링 프로그램, 크롤링 프로그램 만들기, 네이버 블로그 크롤링 프로그램, 이미지 크롤링 프로그램, 쇼핑몰 크롤링 프로그램, Octoparse 사용법, 크롤링 확장프로그램

[크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝!

- Article author: 88-blog.com

- Reviews from users: 42632

Ratings

- Top rated: 3.7

- Lowest rated: 1

- Summary of article content: Articles about [크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝! [크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝! 코딩? No! 몇초만에 누구나 쉽게 하세요!! 크롤링, 스크래핑, 웹크롤러? 그게 뭔데? …

- Most searched keywords: Whether you are looking for [크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝! [크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝! 코딩? No! 몇초만에 누구나 쉽게 하세요!! 크롤링, 스크래핑, 웹크롤러? 그게 뭔데? [크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝! 코딩? No! 몇초만에 누구나 쉽게 하세요!! 크롤링, 스크래핑, 웹크롤러? 그게 뭔데?? 내게 필요한 반복작업 노가다로 하시겠습니까? 쇼핑몰..

- Table of Contents:

크롤링 스크래핑 웹크롤러 그게 뭔데

태그

관련글

댓글0

티스토리툴바

![[크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝!](https://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2FbW3Ctp%2Fbtq3bWoL7dt%2FzdxrpPsaGjhPQJ0H4JYGCk%2Fimg.jpg)

25ê°ì§ ìµê³ ì ë¬´ë£ ì¹ í¬ë¡¤ë¬ ë구

- Article author: ko.101-help.com

- Reviews from users: 8658

Ratings

- Top rated: 4.2

- Lowest rated: 1

- Summary of article content: Articles about 25ê°ì§ ìµê³ ì ë¬´ë£ ì¹ í¬ë¡¤ë¬ ë구 웹(Web) 스파이더, 웹 데이터 추출 소프트웨어 및 웹사이트 스크래핑 프로그램은 인터넷(Internet) 웹 크롤링 기술의 예입니다. 스파이더 봇 또는 스파이더라고도 합니다. …

- Most searched keywords: Whether you are looking for 25ê°ì§ ìµê³ ì ë¬´ë£ ì¹ í¬ë¡¤ë¬ ë구 웹(Web) 스파이더, 웹 데이터 추출 소프트웨어 및 웹사이트 스크래핑 프로그램은 인터넷(Internet) 웹 크롤링 기술의 예입니다. 스파이더 봇 또는 스파이더라고도 합니다. 25ê°ì§ ìµê³ ì ë¬´ë£ ì¹ í¬ë¡¤ë¬ ë구: Open Search Server, Spinn3r, Import.io, BUbiNG, GNU Wget, Webhose.io, Norconex, Dexi.io, Zyte, Apache Nutch

- Table of Contents:

25ê°ì§ ìµê³ ì ë¬´ë£ ì¹ í¬ë¡¤ë¬ ë구(25 Best Free Web Crawler Tools)

25 Best Free Web Crawler Tools

Related posts

[웹크롤러] 웹 사이트를 빠르게 긁어 모으는 상위 20 웹 크롤링 도구

- Article author: gdbs.tistory.com

- Reviews from users: 21820

Ratings

- Top rated: 4.7

- Lowest rated: 1

- Summary of article content: Articles about [웹크롤러] 웹 사이트를 빠르게 긁어 모으는 상위 20 웹 크롤링 도구 Scraper는 데이터 추출 기능이 제한적인 Chrome 확장 프로그램이지만 온라인 조사에 도움이됩니다. 또한 데이터를 Google 스프레드 시트로 내보낼 수 … …

- Most searched keywords: Whether you are looking for [웹크롤러] 웹 사이트를 빠르게 긁어 모으는 상위 20 웹 크롤링 도구 Scraper는 데이터 추출 기능이 제한적인 Chrome 확장 프로그램이지만 온라인 조사에 도움이됩니다. 또한 데이터를 Google 스프레드 시트로 내보낼 수 … 웹 크롤링은 오늘날 많은 분야에서 광범위하게 적용되고 있습니다만, 웹 크롤러 도구가 공개되기 전에는 프로그래밍 기술이 없는 사람들에게는 그저 마법의 단어였던 시절도 있었습니다. 현존하는 최고의 웹 크롤..

- Table of Contents:

태그

관련글

댓글0

공지사항

최근글

인기글

최근댓글

태그

전체 방문자

![[웹크롤러] 웹 사이트를 빠르게 긁어 모으는 상위 20 웹 크롤링 도구](https://img1.daumcdn.net/thumb/R800x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdn%2Fdb5gDx%2Fbtq8aC6VO8Z%2FsbX9Sk5pD6cRwYzFEpAqBK%2Fimg.jpg)

비 전공자를 위한 웹크롤링 프로그램 Octoparse

- Article author: brunch.co.kr

- Reviews from users: 49282

Ratings

- Top rated: 3.2

- Lowest rated: 1

- Summary of article content: Articles about 비 전공자를 위한 웹크롤링 프로그램 Octoparse 기술 메타 분석에 유용한 웹 크롤링 서비스 | 특정 의약분야에 대한 기술동향을 분석하고 있다. 넉넉히 잡아도 20000개는 넘는 방대한 양의 논문을 … …

- Most searched keywords: Whether you are looking for 비 전공자를 위한 웹크롤링 프로그램 Octoparse 기술 메타 분석에 유용한 웹 크롤링 서비스 | 특정 의약분야에 대한 기술동향을 분석하고 있다. 넉넉히 잡아도 20000개는 넘는 방대한 양의 논문을 … 기술 메타 분석에 유용한 웹 크롤링 서비스 | 특정 의약분야에 대한 기술동향을 분석하고 있다. 넉넉히 잡아도 20,000개는 넘는 방대한 양의 논문을 수집하고 분류하기에 구글 스콜라는 너무 불친절했다. Octoparse는 웹 스크랩핑 과정을 쉽게 만들어 주는 툴로 IT분야에 문외한인 나도 알고리즘만 잘 설정하면 자료를 긁어올 수 있다. 특히 논문을 긁어올 때 제목, 기관, 저자, 연도, 피인용수,

- Table of Contents:

[parsehub] 무료 크롤링 프로그램 : 네이버 블로그

- Article author: blog.naver.com

- Reviews from users: 6827

Ratings

- Top rated: 4.4

- Lowest rated: 1

- Summary of article content: Articles about [parsehub] 무료 크롤링 프로그램 : 네이버 블로그 요새 웹 크롤러 대세인 객체 패턴인식 크롤러로, Automation Anywhere보다도 훨씬 가벼우며 더욱 단순하고 코딩에 아예 지식이 전무한 사람도 다룰수 있을 … …

- Most searched keywords: Whether you are looking for [parsehub] 무료 크롤링 프로그램 : 네이버 블로그 요새 웹 크롤러 대세인 객체 패턴인식 크롤러로, Automation Anywhere보다도 훨씬 가벼우며 더욱 단순하고 코딩에 아예 지식이 전무한 사람도 다룰수 있을 …

- Table of Contents:

블로그

악성코드가 포함되어 있는 파일입니다

작성자 이외의 방문자에게는 이용이 제한되었습니다

![[parsehub] 무료 크롤링 프로그램 : 네이버 블로그](https://blogthumb.pstatic.net/MjAyMDA2MDdfMTQ0/MDAxNTkxNDg1MzkwMjI5.XpB1Lrrf1I6J5evCkTgaZZkCBAEFLaOc8ACfVfNDR2Ug.GpCXvOZZFjGov87iMLKg3KdnfMRlMaUkF5SUR0gzlT4g.JPEG.kwonpolice/1591485389432.jpg?type=w2)

전세계에서 가장 빠르고 편한 크롤링 툴이 한국 회사였다 : 리스틀리 최창민 대표 인터뷰 | ㅍㅍㅅㅅ

- Article author: ppss.kr

- Reviews from users: 19151

Ratings

- Top rated: 4.9

- Lowest rated: 1

- Summary of article content: Articles about 전세계에서 가장 빠르고 편한 크롤링 툴이 한국 회사였다 : 리스틀리 최창민 대표 인터뷰 | ㅍㅍㅅㅅ 최창민: ‘리스틀리 크롬 확장 프로그램’을 설치하고, 추출하려는 페이지에서 LISTLY WHOLE을 클릭합니다. 그러면 리스틀리가 엑셀로 정리할만한 … …

- Most searched keywords: Whether you are looking for 전세계에서 가장 빠르고 편한 크롤링 툴이 한국 회사였다 : 리스틀리 최창민 대표 인터뷰 | ㅍㅍㅅㅅ 최창민: ‘리스틀리 크롬 확장 프로그램’을 설치하고, 추출하려는 페이지에서 LISTLY WHOLE을 클릭합니다. 그러면 리스틀리가 엑셀로 정리할만한 …

- Table of Contents:

Primary Sidebar

Footer

웹크롤링 무료프로그램 OCTOPARSE 사용기 :: 꿀팁들은 북마크로

- Article author: bighoneytips.tistory.com

- Reviews from users: 1739

Ratings

- Top rated: 3.3

- Lowest rated: 1

- Summary of article content: Articles about 웹크롤링 무료프로그램 OCTOPARSE 사용기 :: 꿀팁들은 북마크로 웹크롤링 프로그램 OCTOPARSE 사용기를 가져왔답니다! . 다운로드. 웹페이지에서 원하는 부분을 클릭하면 비슷한 DATA를 자동으로 선택해 크롤링을 … …

- Most searched keywords: Whether you are looking for 웹크롤링 무료프로그램 OCTOPARSE 사용기 :: 꿀팁들은 북마크로 웹크롤링 프로그램 OCTOPARSE 사용기를 가져왔답니다! . 다운로드. 웹페이지에서 원하는 부분을 클릭하면 비슷한 DATA를 자동으로 선택해 크롤링을 … 웹크롤링 프로그램 OCTOPARSE 사용기를 가져왔답니다! 다운로드 웹페이지에서 원하는 부분을 클릭하면 비슷한 DATA를 자동으로 선택해 크롤링을 해주는 프로그램입니다 이 프로그램을 활용하기위해서는 순..각종 오류나 문제, 솔루션들 저장하는 공간입니다.

- Table of Contents:

See more articles in the same category here: https://toplist.charoenmotorcycles.com/blog.

[크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝!

반응형

[크롤링프로그램] 웹크롤링이 무료? 3번 클릭으로 웹크롤링 끝!코딩? No! 몇초만에 누구나 쉽게 하세요!!

크롤링, 스크래핑, 웹크롤러? 그게 뭔데??

내게 필요한 반복작업 노가다로 하시겠습니까?

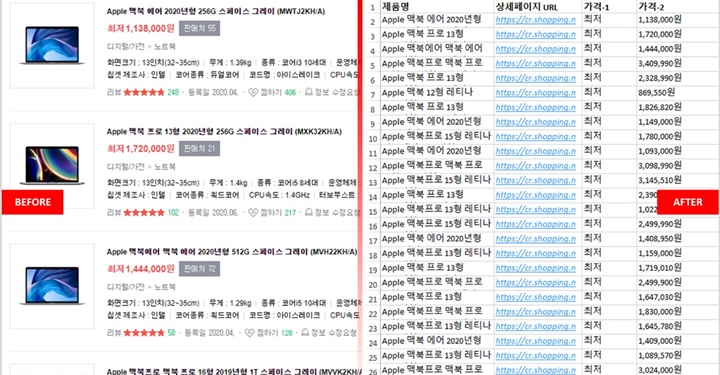

쇼핑몰도 단 3초만에 크롤링 끝!

▶웹크롤링 무료로하기 [클릭]◀

자 그러면 어떻게 하는지 알아볼까요?

크롬, 혹은 웨일브라우저를 사용하셔야 합니다.

일단 아래 설명부터 보고 결정하세요!!

확장프로그램을 설치하셨으면 브라우저 우측 상단에 표시됩니다.

확장프로그램 설치하셨는데 상단에 나타나지 않는다면?

자 확장 브라우저를 설치하셨거나 설치하셨다고 가정하고 시작하겠습니다.

리스틀리 사용방법

크롤링할 사이트에 접속을 합니다.

저는 쿠팡에 접속해서 기저귀를 검색해 테스트 해보았습니다.

크롤링할 페이지가 준비가 되었으면 상단에 리스틀리 아이콘을 클릭합니다.

LISTLY WHOLE을 클릭 합니다.

자 그럼 아래와 같은 페이지가 나타나게 됩니다.

하단에서 추출할 탭을 선택하셔서 추출하세요.

전 테스트로 전체 추출하였습니다.

그리고 우측 상단에 에 엑셀 클릭

해당 페이지를 모두 크롤링하여 아래와 같이 엑셀파일이 생성되었습니다.

글은 길어보이지만 설치제외하고

단 3번의 클릭만으로 끝낸겁니다.

엄청난거 아닙니까?

이것을 입맛에 맞게 수정해주시거나 엑셀 다운받기 전에 필요없는 탭을 빼주시면 됩니다.

저는 필요없는 셀 제거와 상단에 이름만 직접 수정 해봤습니다.

자 여기까지 모두 무료버전의 기능 입니다.

그럼 도대체 유료버전의 기능 뭐가 있을까요?

스케쥴러 원하는 요일과 시간을 설정해 보세요. 시간에 맞춰 데이터를 자동으로 추출하고 이메일로 알려드립니다. 주기적인 데이터 추출도 리스틀리에게 맡겨 주세요. 그룹추출 수천 개의 웹페이지를 한 번에 등록하고 한 장의 엑셀 시트에 모두 담아낼 수 있습니다. 클릭 몇 번이면 충분합니다. 누구나 할 수 있습니다. 이것은 리스틀리의 알고리즘만이 할 수 있는 일입니다. 프록시 서버 페이지 방문할 때 IP 주소를 변경할 수 있습니다. 잠시 대기 페이지 로딩을 마칠 때 까지 기다리는 시간을 설정할 수 있습니다. 자동 스크롤 더 많은 데이터를 불러오기 위해 스크롤이 필요한 경우 자동화할 수 있습니다. 스크롤 중 사라지는 데이터 자동 저장 스크롤 이동 중에 삭제되는 모든 데이터를 자동으로 저장할 수 있습니다. 자동 클릭 더 많은 데이터를 불러오기 위해 클릭이 필요한 경우 자동화할 수 있습니다. HTML 파일보드 .html 파일을 직접 업로드하여 원하는 데이터를 추출할 수 있습니다. 자동 액션 데이터를 불러오기 위해 필요한 모든 종류의 액션 (클릭, 이동, 스크롤) 들을 조합하고 자동화할 수 있습니다. 리스틀리 팀이 액션 스크립트 작성을 도와 드립니다. 스크린샷 데이터 수집 중 에러가 발생했을 때, 페이지 상태를 확인할 수 있습니다. API. 외부 서비스 또는 외부 데이터베이스와 통합할 수 있습니다.

유료버전은 어마무시하네요.

아참!

중소벤처기업부 K-비대면 서비스 바우처 공급기업으로 선정되어서 정부지원금90% 받고 이용할 수 있다고 합니다!

자세한 내용은 홈페이지에서 확인해보세요!!

▶리스틀리 홈페이지 [클릭]◀

반응형

25가지 최고의 무료 웹 크롤러 도구

(Are)SEO 순위, 노출 및 전환 을 향상시키는 도구를 찾고 있습니까 ? 이렇게 하려면 웹 크롤러 도구가 필요합니다. 웹 크롤러는 인터넷(Internet) 을 검색하는 컴퓨터 프로그램입니다 . 웹(Web) 스파이더, 웹 데이터 추출 소프트웨어 및 웹사이트 스크래핑 프로그램은 인터넷(Internet) 웹 크롤링 기술의 예입니다. 스파이더 봇 또는 스파이더라고도 합니다. 오늘은 다운로드할 수 있는 무료 웹 크롤러 도구를 살펴보겠습니다.

25가지 최고의 무료 웹 크롤러 도구(25 Best Free Web Crawler Tools)

웹(Web) 크롤러 도구는 데이터 마이닝 및 분석을 위한 풍부한 정보를 제공합니다. 주요 목적은 인터넷(Internet) 에서 웹 페이지를 색인화하는 것 입니다. 깨진 링크, 중복 콘텐츠 및 누락된 페이지 제목을 감지하고 심각한 SEO 문제를 식별할 수 있습니다. 온라인 데이터를 스크랩하면 다양한 방식으로 비즈니스에 도움이 될 수 있습니다.

여러 웹 크롤러 앱은 모든 웹사이트 URL 에서 데이터를 제대로 크롤링할 수 있습니다 .

에서 데이터를 제대로 크롤링할 수 있습니다 . 이 프로그램은 검색 엔진이 웹사이트를 이해하고 순위를 높일 수 있도록 웹사이트 구조를 개선하는 데 도움이 됩니다.

최고의 도구 목록에서 웹 크롤러 도구 무료 다운로드 목록과 선택할 수 있는 기능 및 비용을 정리했습니다. 목록에는 유료 애플리케이션도 포함됩니다.

1. 검색 서버 열기(1. Open Search Server)

OpenSearchServer 는 무료 웹 크롤러이며 인터넷(Internet) 에서 최고 등급 중 하나입니다 . 사용 가능한 최고의 대안 중 하나입니다.

이것은 완전히 통합된 솔루션 (completely integrated solution) 입니다.

입니다. Open Search Server 는 무료 오픈 소스인 웹 크롤링 및 검색 엔진입니다.

는 무료 오픈 소스인 웹 크롤링 및 검색 엔진입니다. 비용 효율적인 원스톱 솔루션입니다.

포괄적인 검색 기능 세트와 고유한 인덱싱 전략을 구성할 수 있는 가능성이 함께 제공됩니다.

크롤러는 거의 모든 것을 인덱싱할 수 있습니다.

전체 텍스트, 부울 및 음성 검색 (full-text, boolean, and phonetic searches) 중에서 선택할 수 있습니다.

중에서 선택할 수 있습니다. 17개 언어 (17 different languages) 중에서 선택할 수 있습니다 .

중에서 선택할 수 있습니다 . 자동 분류가 이루어집니다.

자주 일어나는 일에 대한 시간표를 만들 수 있습니다.

2. Spinn3r

Spinn3r 웹 크롤러 프로그램을 사용 하면 (Spinn3r)블로그, 뉴스, 소셜 네트워킹 사이트, RSS 피드 및 ATOM 피드(blogs, news, social networking sites, RSS feeds, and ATOM feeds) 에서 콘텐츠를 완전히 추출할 수 있습니다 .

인덱싱 작업의 (of the indexing work) 95% 를 처리하는 번개처럼 빠른 API (lightning-fast API that handles) 와 함께 제공됩니다 .

와 함께 제공됩니다 . 이 웹 크롤링 애플리케이션에는 고급 (Advanced) 스팸 보호 기능이 포함되어 있어 스팸 및 부적절한 언어 사용을 제거하여 데이터 보안을 향상시킵니다.

스팸 보호 기능이 포함되어 있어 스팸 및 부적절한 언어 사용을 제거하여 데이터 보안을 향상시킵니다. 웹 스크레이퍼는 실시간 콘텐츠를 제공하기 위해 수많은 소스에서 업데이트를 찾기 위해 웹을 지속적으로 검색합니다.

Google 과 동일한 방식으로 콘텐츠를 인덱싱 하고 추출된 데이터는 JSON 파일로 저장됩니다.

과 동일한 방식으로 콘텐츠를 인덱싱 하고 추출된 데이터는 파일로 저장됩니다. Parser API를 (Parser API) 사용하면 임의의 웹 URL에 대한 정보를 빠르게 구문 분석하고 관리할 수 있습니다 (URLs) .

사용하면 임의의 웹 URL에 대한 정보를 빠르게 구문 분석하고 관리할 수 . Firehose API 는 방대한 양의 데이터에 대한 대량 액세스를 위해 설계되었습니다.

는 방대한 양의 데이터에 대한 대량 액세스를 위해 설계되었습니다. 간단한 HTTP 헤더는 (Simple HTTP headers are used) Spinn3r의 모든 API (APIs) 를 인증하는 데 사용됩니다 .

Spinn3r의 모든 를 인증하는 데 사용됩니다 . 이것은 무료로 다운로드할 수 있는 웹 크롤러 도구입니다.

Classifier API를(Classifier API) 사용하면 개발자가 기계 학습 기술로 레이블을 지정할 텍스트(또는 URL)를 전송할 수 있습니다 .(URLs)

또한 읽기: (Also Read:) UAE에서 차단된 사이트에 액세스하는 방법(How to Access Blocked Sites in UAE)

3. Import.io

Import.io 를 사용하면 몇 분 만에 수백만 개의 웹 페이지를 스크랩하고 코드를 한 줄도 작성하지 않고도 필요에 따라 1000개 이상의 API 를 구성할 수 있습니다.(APIs)

이제 프로그래밍 방식으로 작동할 수 있으며 이제 데이터를 자동으로 검색할 수 있습니다.

(Extract) 버튼 한 번으로 여러 페이지에서 데이터를 추출 합니다.

버튼 한 번으로 여러 페이지에서 데이터를 페이지가 매겨진 목록 (automatically recognize paginated lists) 을 자동으로 인식 하거나 다음 페이지를 클릭할 수 있습니다.

을 자동으로 인식 하거나 다음 페이지를 클릭할 수 있습니다. 몇 번의 클릭만으로 온라인 데이터를 앱이나 웹사이트에 통합할 수 있습니다.

(Create) 페이지 번호 및 카테고리 이름과 같은 패턴을 사용하여 몇 초 안에 필요한 모든 URL 을 (URLs) 만듭니다 .

페이지 번호 및 카테고리 이름과 같은 패턴을 사용하여 몇 초 안에 필요한 모든 Import.io 는 페이지에서 데이터를 가져오는 방법을 간단하게 보여줍니다. 데이터세트에서 열을 선택하고 페이지에서 시선을 사로잡는 항목을 가리키기만 하면 됩니다 . (Simply)

는 페이지에서 데이터를 가져오는 방법을 간단하게 보여줍니다. 데이터세트에서 열을 선택하고 페이지에서 시선을 사로잡는 항목을 가리키기만 하면 됩니다 그들의 웹사이트에서 견적을 받을 (receive a quotation on their website) 수 있습니다 .

수 있습니다 . 목록 페이지의 링크는 추가 정보가 있는 상세 페이지로 연결됩니다.

Import.io 를 사용 하여 세부 정보 페이지의 모든 데이터를 한 번에 가져오기 위해 이들을 결합할 수 있습니다.

4. 부빙(4. BUbiNG)

(BUbiNG)차세대 웹 크롤러 도구인 BUbiNG는 UbiCrawler에 대한 저자의 경험과 해당 주제에 대한 10년 간의 연구 결과 가 집약 된 것입니다.(UbiCrawler)

호스트 및 IP 기반의 엄격한 정중함 표준을 준수하면서 단일 에이전트가 초당 수천 페이지를 크롤링할 수 있습니다.

작업 분배는 배치 기술에 의존하는 이전의 오픈 소스 분산 크롤러와 달리 매우 높은 처리량을 제공하는 최신 고속 프로토콜을 기반으로 합니다.

그것은 거의 중복을 감지하기 위해 벗겨진 페이지의 지문을 (fingerprint of a stripped page to detect near-duplicates) 사용합니다 .

사용합니다 . BUbiNG는 완전히 분산된 오픈 소스 Java 크롤러 (open-source Java crawler) 입니다.

입니다. 그것은 많은 병렬성을 가지고 있습니다.

이 제품을 사용하는 사람들이 많이 있습니다.

빨라요.

대규모 크롤링(large-scale crawling) 이 가능 합니다.

5. GNU Wget

GNU Wget 은 무료로 다운로드할 수 있는 웹 크롤러 도구이며 C로 작성된 오픈 소스 소프트웨어 프로그램으로 HTTP, HTTPS, FTP 및 FTPS(HTTP, HTTPS, FTP, and FTPS) 를 통해 파일을 가져올 수 있습니다 .

이 응용 프로그램의 가장 독특한 측면 중 하나는 다양한 언어로 NLS 기반 메시지 파일을 만드는 기능입니다.

REST 및 RANGE (REST and RANGE) 를 사용하여 중단된 다운로드를 다시 시작할 ( restart downloads) 수 있습니다 .

를 사용하여 중단된 수 있습니다 . 또한 필요한 경우 다운로드한 문서의 절대 링크를 상대 링크로 변환할 수도 있습니다.

파일 이름과 미러 디렉토리에서 재귀적으로 와일드카드를 사용합니다.

다양한 언어에 대한 NLS 기반 메시지 파일 .

기반 메시지 파일 . 미러링하는 동안 문서를 다시 다운로드해야 하는지 여부를 결정하기 위해 로컬 파일 타임스탬프가 평가 됩니다.(local file timestamps are evaluated)

또한 읽기: (Also Read:) Windows 10에서 파일 또는 폴더를 복사할 때 지정되지 않은 오류 수정(Fix Unspecified error when copying a file or folder in Windows 10)

6. 웹호스.io(6. Webhose.io)

Webhose.io 는 다양한 소스에 걸쳐 있는 다양한 필터를 사용하여 데이터를 스캔하고 여러 언어로(several languages) 키워드를 추출할 수 있는 환상적인 웹 크롤러 애플리케이션입니다 .

아카이브를 통해 사용자는 이전 데이터를 볼 (view previous data) 수도 있습니다 .

수도 있습니다 . 또한 webhose.io의 크롤링 데이터 검색은 최대 80개 언어로 제공됩니다 (80 languages) .

. 침해된 모든 개인 식별 정보를 한 곳에서 찾을 수 있습니다.

(Investigate) 사이버 위협에 대한 다크넷 및 메시징 애플리케이션을 조사 합니다.

사이버 위협에 대한 다크넷 및 메시징 애플리케이션을 XML, JSON 및 RSS 형식 (XML, JSON, and RSS formats) 도 스크랩한 데이터에 액세스할 수 있습니다.

도 스크랩한 데이터에 액세스할 수 있습니다. 그들의 웹사이트에서 견적을 받을 수 있습니다.

사용자는 Webhose.io (Webhose.io) 에서 구조화된 데이터를 간단히 인덱싱하고 검색할 수 있습니다 .

에서 구조화된 데이터를 간단히 인덱싱하고 검색할 수 있습니다 . 모든 언어로 미디어 매체를 모니터링하고 분석할 수 있습니다.

게시판 및 포럼에서 토론을 팔로우할 수 있습니다.

이를 통해 웹 전체에서 주요 블로그 게시물을 추적할 수 있습니다.

7. 노르코넥스(7. Norconex)

Norconex 는 오픈 소스 웹 크롤러 앱을 찾는 기업을 위한 훌륭한 리소스입니다.

이 모든 기능을 갖춘 수집기를 사용하거나 프로그램에 통합할 수 있습니다.

페이지의 추천 이미지 (page’s featured image) 를 가져올 수도 있습니다 .

를 가져올 수도 있습니다 . Norconex 는 모든 웹사이트의 콘텐츠를 크롤링할 수 있는 기능을 제공합니다.

는 모든 웹사이트의 콘텐츠를 크롤링할 수 있는 기능을 제공합니다. 모든 운영 체제를 활용하는 것이 가능합니다.

이 웹 크롤러 소프트웨어는 단일 평균 용량 서버에서 수백만 페이지를 크롤링할 수 있습니다.

또한 콘텐츠 및 메타데이터를 수정하기 위한 도구 세트도 포함되어 있습니다.

현재 작업 중인 문서의 메타데이터를 가져옵니다.

JavaScript 렌더링 페이지 (JavaScript-rendered pages) 가 지원됩니다.

가 지원됩니다. 여러 언어를 감지할 수 있습니다.

번역 지원을 가능하게 합니다.

크롤링 속도가 변경될 수 있습니다.

수정 또는 제거된 문서가 식별됩니다.

이것은 완전 무료 웹 크롤러 프로그램입니다.

8. 덱시아이오(8. Dexi.io)

Dexi.io 는 모든 웹사이트에서 정보를 스크랩할 수 있는 브라우저 기반 웹 크롤러 앱입니다.

추출기, 크롤러 및 파이프 (Extractors, crawlers, and pipes) 는 긁는 작업을 수행하는 데 사용할 수 있는 세 가지 유형의 로봇입니다.

는 긁는 작업을 수행하는 데 사용할 수 있는 세 가지 유형의 로봇입니다. 시장 발전은 Delta (Delta) 보고서 를 사용하여 예측됩니다 .

보고서 를 사용하여 예측됩니다 . 수집된 데이터는 보관하기 전에 Dexi.io의 서버에 2주 동안 보존되거나 추출된 데이터를 JSON 또는 CSV 파일 (JSON or CSV files) 로 즉시 내보낼 수 있습니다 .

로 즉시 내보낼 수 있습니다 . 그들의 웹사이트에서 견적을 받을 수 있습니다.

품질 보증 및 지속적인 유지 보수와 같은 전문 서비스가 제공됩니다.

실시간 데이터 요구 사항을 충족하는 데 도움이 되는 상용 서비스를 제공합니다.

unlimited number of SKUs/products 재고 및 가격을 추적할 수 있습니다 .

재고 및 가격을 추적할 수 있습니다 . 라이브 대시보드 및 전체 제품 분석을 사용하여 데이터를 통합할 수 있습니다.

웹 기반으로 구성되고 바로 사용할 수 있는 제품 데이터를 준비하고 헹구는 데 도움이 됩니다.

또한 읽기: (Also Read:) Android에서 PC로 파일을 전송하는 방법(How to Transfer Files from Android to PC)

9. 자이테(9. Zyte)

Zyte 는 수만 명의 개발자가 중요한 정보를 찾을 수 있도록 지원하는 클라우드 기반 데이터 추출 도구입니다. 또한 최고의 무료 웹 크롤러 앱 중 하나입니다.

사용자는 코딩을 몰라도 오픈 소스 비주얼 스크래핑 애플리케이션을 사용하여 웹 페이지를 스크래핑할 수 있습니다.

Zyte (Crawlera) 에서 사용하는 복잡한 프록시 로테이터인 Crawlera (a complex proxy rotator used by Zyte) 를 사용하면 사용자가 봇 대응책을 피하면서 크거나 봇으로 보호되는 사이트를 쉽게 크롤링할 수 있습니다.

에서 를 사용하면 사용자가 봇 대응책을 피하면서 크거나 봇으로 보호되는 사이트를 쉽게 크롤링할 수 있습니다. 귀하의 온라인 정보는 일정에 따라 일관되게 제공됩니다. 따라서 프록시를 관리하는 대신 데이터를 얻는 데 집중할 수 있습니다.

스마트 브라우저 기능 및 렌더링으로 인해 브라우저 계층을 대상으로 하는 안티봇을 이제 쉽게 관리할 수 있습니다.

그들의 웹사이트에서 견적을 받을 수 있습니다.

사용자는 간단한 HTTP API를 사용하여 수많은 IP 및 지역에서 크롤링 ( crawl from numerous IPs and regions using a simple HTTP API) 할 수 있으므로 프록시 유지 관리가 필요하지 않습니다.

할 수 있으므로 프록시 유지 관리가 필요하지 않습니다. 필요한 정보를 획득하여 시간을 절약하면서 현금을 창출하는 데 도움이 됩니다.

코딩 및 스파이더 유지 관리 시간을 절약하면서 웹 데이터를 대규모로 추출할 수 있습니다.

10. 아파치 너치(10. Apache Nutch)

Apache Nutch 는 의심할 여지 없이 최고의 오픈 소스 웹 크롤러 앱 목록의 맨 위에 있습니다.

단일 기계에서 작동할 수 있습니다. 그러나 Hadoop (Hadoop) 클러스터 에서 가장 잘 수행 됩니다.

클러스터 에서 가장 잘 수행 됩니다. 인증을 위해 NTLM 프로토콜 (NTLM protocol) 이 사용됩니다.

이 사용됩니다. Hadoop 을 통한 분산 파일 시스템이 있습니다 .

을 통한 분산 파일 시스템이 있습니다 . 데이터 마이닝에 적합하고 확장 가능한 (adaptable and scalable for data mining) 잘 알려진 오픈 소스 온라인 데이터 추출 소프트웨어 프로젝트입니다 .

잘 알려진 오픈 소스 온라인 데이터 추출 소프트웨어 프로젝트입니다 . 전 세계의 많은 데이터 분석가, 과학자, 응용 프로그램 개발자 및 웹 텍스트 마이닝 전문가가 사용합니다.

Java 기반 크로스 플랫폼 솔루션 (Java-based cross-platform solution) 입니다.

입니다. 기본적으로 가져오기 및 구문 분석은 독립적으로 수행됩니다.

데이터는 XPath 및 네임스페이스 (XPath and namespaces) 를 사용하여 매핑됩니다 .

를 사용하여 매핑됩니다 . 링크 그래프 데이터베이스가 포함되어 있습니다.

11. 비주얼 스크래퍼(11. VisualScraper)

VisualScraper 는 (VisualScraper)인터넷(Internet) 에서 데이터를 추출하기 위한 또 다른 환상적인 비코딩 웹 스크레이퍼입니다 .

간단한 포인트 앤 클릭 사용자 인터페이스를 제공 (simple point-and-click user interface) 합니다 .

합니다 . 또한 데이터 보급 및 소프트웨어 추출기 구축과 같은 온라인 스크래핑 서비스를 제공합니다.

그것은 당신의 경쟁자도 주시합니다.

사용자는 Visual Scraper (Visual Scraper) 를 사용하여 특정 시간에 실행되도록 프로젝트를 예약하거나 매분, 일, 주, 월 및 연도마다 시퀀스를 반복할 수 있습니다.

를 사용하여 특정 시간에 실행되도록 프로젝트를 예약하거나 매분, 일, 주, 월 및 연도마다 시퀀스를 반복할 수 있습니다. 그것은 더 저렴하고 더 효과적입니다.

말하는 코드조차 없습니다.

이것은 완전 무료 웹 크롤러 프로그램입니다.

실시간 데이터는 여러 웹 페이지에서 추출하여 CSV, XML, JSON 또는 SQL 파일 (CSV, XML, JSON, or SQL files) 로 저장할 수 있습니다 .

로 저장할 수 있습니다 . 사용자는 정기적으로 뉴스, 업데이트 및 포럼 게시물을 추출 (regularly extract news, updates, and forum posts) 하는 데 사용할 수 있습니다 .

하는 데 사용할 수 있습니다 . 데이터는 100% accurate and customized .

더 읽어보기: (Also Read:) 중소기업을 위한 15가지 최고의 무료 이메일 제공업체(15 Best Free Email Providers for Small Business)

12. 웹스핑크스(12. WebSphinx)

WebSphinx 는 설정 및 사용이 간편한 환상적인 개인용 무료 웹 크롤러 앱입니다.

인터넷의 제한된 부분을 자동으로 스캔 (scan a limited portion of the Internet automatically) 하려는 정교한 웹 사용자와 Java 프로그래머를 위해 설계되었습니다 .

하려는 정교한 웹 사용자와 프로그래머를 위해 설계되었습니다 . 이 온라인 데이터 추출 솔루션에는 Java 클래스 라이브러리와 대화형 프로그래밍 환경이 포함되어 있습니다.

클래스 라이브러리와 대화형 프로그래밍 환경이 포함되어 있습니다. 페이지를 연결하여 검색하거나 인쇄할 수 있는 단일 문서를 만들 수 있습니다.

(Extract all text) 일련의 페이지에서 주어진 패턴에 맞는 모든 텍스트를 추출합니다 .

일련의 페이지에서 주어진 패턴에 맞는 (Web) 이 패키지 덕분에 이제 웹 크롤러를 Java 로 작성할 수 있습니다. (Java)

이 패키지 덕분에 이제 크롤러를 Crawler Workbench와 WebSPHINX 클래스 라이브러리 (Crawler Workbench and the WebSPHINX class library) 는 모두 WebSphinx에 포함되어 있습니다.

는 모두 WebSphinx에 포함되어 있습니다. Crawler Workbench 는 웹 크롤러를 사용자 정의하고 작동할 수 있는 그래픽 사용자 인터페이스입니다.

는 웹 크롤러를 사용자 정의하고 작동할 수 있는 그래픽 사용자 인터페이스입니다. 그래프는 웹 페이지 그룹에서 만들 수 있습니다.

(Save)오프라인 읽기를 위해 페이지를 로컬 드라이브에 저장 합니다.

13. 아웃윗 허브(13. OutWit Hub)

OutWit Hub 플랫폼(Platform) 은 데이터 인식 및 추출 기능의 광범위한 라이브러리가 있는 커널로 구성되며, 각각 커널의 기능을 활용하는 다양한 앱이 생성될 수 있습니다.

이 웹 크롤러 응용 프로그램은 사이트를 검색하고 액세스 가능한 방식으로 검색 한 데이터를 보존 할 수 있습니다. (scan through sites and preserve the data)

다양한 요구 사항을 수용할 수 있도록 최대한 많은 기능을 갖춘 다목적 수확기입니다.

허브 (Hub) 는 오랫동안 주변에 있었습니다.

는 오랫동안 주변에 있었습니다. 이것은 코딩 방법을 알고 있지만 PHP 가 데이터 추출에 항상 이상적인 옵션은 아님을 인식하는 비기술적 사용자 및 IT 전문가를 위한 유용하고 다양한 플랫폼으로 발전했습니다.

가 데이터 추출에 항상 이상적인 옵션은 아님을 인식하는 비기술적 사용자 및 IT 전문가를 위한 유용하고 다양한 플랫폼으로 발전했습니다. OutWit Hub는 요구 사항에 따라 적당하거나 방대한 양의 데이터를 스크랩하기 위한 단일 인터페이스를 제공합니다. (single interface for scraping modest or massive amounts of data)

이를 통해 브라우저에서 직접 웹 페이지를 스크랩하고 요구 사항에 따라 데이터를 가져와 준비하는 자동화 에이전트를 구성할 수 있습니다.

그들의 웹사이트 에서 견적을 받을(receive a quotation) 수 있습니다 .

14. 스크래피(14. Scrapy)

Scrapy 는 확장 가능한 웹 크롤러를 구축하기 위한 Python 온라인 스크래핑 프레임워크입니다.

프록시 미들웨어 및 쿼리 질문 (proxy middleware and querying questions) 과 같이 웹 크롤러를 생성하기 어렵게 만드는 모든 특성을 처리하는 완전한 웹 크롤링 프레임워크입니다 .

과 같이 웹 크롤러를 생성하기 어렵게 만드는 모든 특성을 처리하는 완전한 웹 크롤링 프레임워크입니다 . 데이터 추출 규칙을 작성한 다음 나머지는 Scrapy 가 처리하도록 할 수 있습니다.

가 처리하도록 할 수 있습니다. 그렇게 설계되었기 때문에 코어를 수정하지 않고도 새로운 기능을 쉽게 추가할 수 있습니다.

Linux, Windows, Mac OS X 및 BSD 시스템에서 (Linux, Windows, Mac OS X, and BSD systems) 작동하는 Python 기반 프로그램입니다 .

작동하는 Python 기반 프로그램입니다 . 이것은 완전 무료 유틸리티입니다.

이 라이브러리는 웹 크롤러를 사용자 정의하고 웹에서 방대한 규모로 데이터를 추출하기 위해 바로 사용할 수 있는 구조를 프로그래머에게 제공합니다.

또한 읽기: (Also Read:) 9 최고의 무료 데이터 복구 소프트웨어(2022)(9 Best Free Data Recovery Software (2022))

15. 모젠다(15. Mozenda)

Mozenda 는 최고의 무료 웹 크롤러 앱이기도 합니다. 비즈니스 지향적인 클라우드 기반의 셀프 웹(Web) 스크래핑 프로그램입니다. Mozenda 는 70억 페이지가 넘는 스크랩 페이지(7 billion pages scraped) 를 보유하고 있으며 전 세계에 기업 고객을 보유하고 있습니다.

Mozenda의 웹 스크래핑 기술은 스크립트 및 엔지니어 고용에 대한 요구 사항을 제거합니다.

데이터 수집 속도가 5배 빨라 (speeds up data collecting by five times) 집니다 .

집니다 . Mozenda의 포인트 앤 클릭 기능으로 웹사이트에서 텍스트, 파일, 이미지 및 PDF 정보를 스크랩할 수 있습니다. (PDF)

데이터 파일을 구성하여 게시를 준비할 수 있습니다.

Mozeda의 API를 사용하여 TSV, CSV, XML, XLSX 또는 JSON으로 (TSV, CSV, XML, XLSX, or JSON using Mozeda’s API) 직접 내보낼 수 있습니다 .

직접 내보낼 수 있습니다 . 중요한 결정을 내릴 수 있도록 Mozenda의 정교한 데이터 랭글링 을 사용하여 정보를 정리할 수 있습니다. (Data Wrangling)

Mozenda의 파트너 플랫폼 중 하나를 사용하여 몇 가지 플랫폼에서 데이터를 통합하거나 맞춤형 데이터 통합을 설정할 수 있습니다.

16. 사이오텍 웹카피(16. Cyotek Webcopy)

Cyotek Webcopy 는 웹사이트의 콘텐츠를 로컬 장치에 자동으로 다운로드할 수 있는 무료 웹 크롤러 도구입니다.

선택한 웹사이트의 콘텐츠를 스캔하여 다운로드합니다.

복제할 웹사이트 부분과 복잡한 구조를 사용하는 방법을 선택할 수 있습니다.

새로운 로컬 경로는 스타일시트, 사진 및 기타 페이지와 (stylesheets, pictures, and other pages) 같은 웹사이트 리소스에 대한 링크를 리디렉션합니다 .

같은 웹사이트 리소스에 대한 링크를 리디렉션합니다 . 웹사이트의 HTML 마크업을 보고 다른 (HTML) 웹사이트, 사진, 비디오, 파일 다운로드 (websites, photos, videos, file downloads) 등과 같은 연결된 리소스를 찾으려고 시도합니다 .

등과 같은 연결된 리소스를 찾으려고 시도합니다 . 웹 사이트를 크롤링하고 원본의 허용 가능한 사본을 만들기 위해 보이는 모든 것을 다운로드할 수 있습니다.

17. 공통 크롤링(17. Common Crawl)

Common Crawl 은 유용한 통찰력을 얻기 위해 데이터를 탐색하고 분석하는 데 관심이 있는 모든 사람을 대상으로 했습니다.

운영을 적절하게 운영하기 위해 기부금에 의존 하는 501(c)(3) 비영리 단체 입니다. (501(c)(3) non-profit )

Common Crawl 을 활용하고자 하는 사람은 돈을 들이거나 문제를 일으키지 않고 그렇게 할 수 있습니다.

을 활용하고자 하는 사람은 돈을 들이거나 문제를 일으키지 않고 그렇게 할 수 있습니다. Common Crawl 은 교육, 연구 및 분석에 사용할 수 있는 말뭉치입니다. (teaching, research, and analysis.)

은 다른 사람들이 Common Crawl (Common Crawl) 데이터 를 활용하여 발견한 놀라운 발견에 대해 배울 기술적 기술이 없는 경우 기사를 읽어야 합니다 .

데이터 를 활용하여 발견한 놀라운 발견에 대해 배울 기술적 기술이 없는 경우 기사를 읽어야 합니다 . 교사는 이러한 도구를 사용하여 데이터 분석을 가르칠 수 있습니다.

또한 읽기: (Also Read:) 한 Google 드라이브에서 다른 Google 드라이브로 파일을 이동하는 방법(How to Move Files from One Google Drive to Another)

18. 셈러쉬(18. Semrush)

Semrush 는 기술적인 (Semrush)SEO 문제 에 대해 웹사이트의 페이지와 구조를 검사하는 웹사이트 크롤러 앱입니다 . 이러한 문제를 수정하면 검색 결과를 향상시키는 데 도움이 될 수 있습니다.

SEO, 시장 조사, 소셜 미디어 마케팅 및 광고 (SEO, market research, social media marketing, and advertising) 를 위한 도구가 있습니다 .

를 위한 도구가 있습니다 . 사용자 친화적 인 UI가 있습니다.

Metadata, HTTP/HTTPS, directives, status codes, duplicate content, page response speed, internal linking, image sizes, structured data 및 기타 요소를 검사합니다.

및 기타 요소를 검사합니다. 웹사이트를 빠르고 간단하게 감사할 수 있습니다.

로그 파일 분석에 (analysis of log files) 도움이 됩니다 .

도움이 됩니다 . 이 프로그램은 웹 사이트 문제를 쉽게 볼 수 있는 대시보드를 제공합니다.

19. Sitechecker.pro

Sitechecker.pro 는 또 다른 최고의 무료 웹 크롤러 앱입니다. SEO 순위 를 높이는 데 도움이 되는 웹사이트용 SEO 검사기입니다.(SEO)

웹 페이지의 구조를 쉽게 시각화할 수 있습니다.

클라이언트가 이메일을 통해 받을 수 있는 페이지 내 SEO 감사 보고서 (on-page SEO audit report) 를 생성합니다 .

를 생성합니다 . 이 웹 크롤러 도구는 웹사이트의 내부 및 외부 링크 (website’s internal and external links) 를 볼 수 있습니다 .

를 볼 수 있습니다 . 웹사이트의 속도를 결정하는 (determining your website’s speed) 데 도움이 됩니다 .

데 도움이 됩니다 . Sitechecker.pro를 사용 하여 방문 페이지의 색인 생성 문제를 확인할 ( check for indexing problems on landing pages) 수도 있습니다 .

수도 있습니다 . 해커 공격으로부터 방어(defend against hacker attacks) 하는 데 도움이 됩니다 .

20. 웹하비(20. Webharvy)

Webharvy 는 간단한 포인트 앤 클릭 인터페이스를 갖춘 웹 스크래핑 도구입니다. 코딩을 잘 못하는 분들을 위해 준비했습니다.

라이센스 비용은 (cost of a license) $ $139 부터 시작합니다 .

$ 부터 시작합니다 . WebHarvy의 내장 브라우저를 사용하여 온라인 사이트를 로드하고 마우스 클릭을 사용하여 스크랩할 데이터를 선택합니다.

웹 사이트에서 텍스트, 사진, URL 및 이메일 (text, photos, URLs, and emails) 을 자동으로 스크랩 ( scrape) 하여 다양한 형식으로 저장할 수 있습니다.

을 자동으로 하여 다양한 형식으로 저장할 수 있습니다. 프록시 서버 또는 VPN (Proxy servers or a VPN) 을 사용 (can be used) 하여 대상 웹사이트에 액세스할 수 있습니다.

하여 대상 웹사이트에 액세스할 수 있습니다. 데이터를 스크랩한다고 해서 프로그래밍이나 앱을 만들 필요는 없습니다.

프록시 서버 또는 VPN (VPNs) 을 사용하여 대상 웹 사이트에 액세스 하여 익명으로 스크랩하고 웹 서버에서 웹 스크랩 소프트웨어를 금지하는 것을 방지할 수 있습니다 .

을 사용하여 대상 웹 사이트에 액세스 하여 익명으로 스크랩하고 웹 서버에서 웹 스크랩 소프트웨어를 금지하는 것을 방지할 수 있습니다 . WebHarvy 는 웹사이트의 데이터 패턴을 자동으로 식별합니다.

는 웹사이트의 데이터 패턴을 자동으로 식별합니다. 웹 페이지에서 개체 목록을 스크랩해야 하는 경우 다른 작업을 수행할 필요가 없습니다.

또한 읽기: (Also Read:) Windows 10용 상위 8가지 무료 파일 관리자 소프트웨어(Top 8 Free File Manager Software For Windows 10)

21. 넷스피크 스파이더(21. NetSpeak Spider)

NetSpeak Spider 는 일일 (NetSpeak Spider)SEO 감사(SEO audits, quickly identifying problems, conducting systematic analysis, and scraping webpages) 를 위한 데스크탑 웹 크롤러 앱으로 , 문제를 신속하게 식별하고, 체계적인 분석을 수행하고, 웹페이지를 스크랩 합니다.

이 웹 크롤링 응용 프로그램은 RAM (RAM) 사용 을 최소화하면서 큰 웹 페이지를 평가하는 데 탁월 합니다.

사용 을 최소화하면서 큰 웹 페이지를 평가하는 데 탁월 합니다. CSV 파일은 웹 크롤링 데이터에서 쉽게 가져오고 내보낼 수 있습니다.

파일은 웹 크롤링 데이터에서 쉽게 가져오고 내보낼 수 있습니다. 몇 번의 클릭만으로 이러한 문제와 수백 가지의 심각한 다른 웹사이트 SEO 문제를 식별할 수 있습니다.

문제를 식별할 수 있습니다. 이 도구는 상태 코드, 크롤링 및 색인 생성 지침, 웹사이트 구조, 리디렉션 등 웹사이트의 페이지 최적화를 평가하는 데 도움이 됩니다.

Google Analytics 및 Yandex (Google Analytics and Yandex) 의 데이터를 내보낼 수 있습니다.

의 데이터를 내보낼 수 있습니다. 웹사이트 페이지, 트래픽, 전환, 타겟, 전자상거래 (E-commerce) 설정 까지 데이터 범위, 기기 종류 및 세분화를 고려하십시오 .

설정 까지 데이터 범위, 기기 종류 및 세분화를 고려하십시오 . 월간 구독 (monthly subscriptions) 은 $21 부터 시작합니다 .

은 부터 시작합니다 . 깨진 링크와 사진은 페이지, 텍스트, 중복 제목 및 메타 설명 태그, (Broken links and photos will be detected)H1(H1s) 과 같은 중복 자료와 마찬가지로 SEO 크롤러 에 의해 감지됩니다 .

22. 유아이패스(22. UiPath)

UiPath 는 로봇 절차를 자동화할 수 있는 웹 크롤러 온라인 스크래핑 도구입니다. 대부분의 타사 프로그램에 대한 온라인 및 데스크톱 데이터 크롤링을 자동화합니다.

Windows 에 로봇 프로세스 자동화 애플리케이션을 설치할 수 있습니다 .

에 로봇 프로세스 자동화 애플리케이션을 설치할 수 있습니다 . 많은 웹 페이지에서 표 형식 및 패턴 기반 형식으로 데이터를 추출할 수 있습니다.

UiPath는 즉시 추가 크롤링 ( additional crawls right out of the box) 을 수행할 수 있습니다 .

을 수행할 수 있습니다 . 보고는 로봇을 추적하므로 언제든지 문서를 참조할 수 있습니다.

관행을 표준화하면 결과가 더 효율적이고 성공적일 것입니다.

월간 구독 은 (Monthly subscriptions) $420 부터 시작 합니다.

부터 시작 합니다. Marketplace의 200개 이상의 기성 구성 요소 (more than 200 ready-made components) 는 팀에 더 짧은 시간에 더 많은 시간을 제공합니다.

는 팀에 더 짧은 시간에 더 많은 시간을 제공합니다. UiPath 로봇은 귀하의 요구 사항을 충족하는 정확한 방법을 따라 규정 준수를 높입니다.

로봇은 귀하의 요구 사항을 충족하는 정확한 방법을 따라 규정 준수를 높입니다. 기업은 프로세스를 최적화하고 경제를 인식하며 통찰력을 제공함으로써 더 낮은 비용으로 빠른 디지털 혁신을 달성할 수 있습니다.

또한 읽기: (Also Read:) 디버거 감지 오류를 수정하는 방법(How to Fix Debugger Detected Error)

23. 헬륨 스크레이퍼(23. Helium Scraper)

Helium Scraper 는 요소 간의 연관성이 거의 없을 때 가장 잘 작동하는 시각적 온라인 데이터 웹 크롤링 응용 프로그램입니다. 기본 수준에서 사용자의 크롤링 요구 사항을 충족할 수 있습니다.

코딩이나 구성이 필요하지 않습니다.

명확하고 쉬운 사용자 인터페이스를 통해 지정된 목록에서 활동을 선택하고 추가할 수 있습니다.

특수한 크롤링 요구 사항을 위한 온라인 템플릿도 제공됩니다.

화면 밖에서 여러 Chromium 웹 브라우저가 사용 ( Chromium web browsers are utilized) 됩니다.

됩니다. 가능한 한 많은 데이터를 얻으려면 동시 브라우저 수를 늘리십시오.

고유한 작업을 정의하거나 보다 복잡한 인스턴스에 대해 사용자 정의 JavaScript 를 활용하십시오. (JavaScript)

개인용 컴퓨터 또는 전용 Windows 서버에 설치할 수 있습니다.

서버에 설치할 수 있습니다. 라이선스 는 licenses start at $99 거기에서 올라갑니다.

24. 80레그(24. 80Legs)

2009년에 80Legs 는 온라인 데이터에 더 쉽게 접근할 수 있도록 하기 위해 설립되었습니다. 최고의 무료 웹 크롤러 도구 중 하나입니다. 처음에 회사는 다양한 고객에게 웹 크롤링 서비스를 제공하는 데 중점을 두었습니다.

당사의 광범위한 웹 크롤러 앱은 개인화된 정보를 제공합니다.

크롤링 속도는 웹사이트 트래픽에 따라 자동으로 조정됩니다 (automatically adjusted based on website traffic) .

. 80legs를 통해 로컬 환경이나 컴퓨터에 결과를 다운로드할 수 있습니다.

URL 만 제공 하면 웹사이트를 크롤링할 수 있습니다.

만 제공 하면 웹사이트를 크롤링할 수 있습니다. 월간 구독은 $29 per month 부터 시작 합니다.

부터 시작 합니다. SaaS 를 통해 웹 크롤링을 구성하고 수행할 수 있습니다.

를 통해 웹 크롤링을 구성하고 수행할 수 있습니다. 다양한 IP 주소에서 사이트를 볼 수 있는 많은 서버가 있습니다.

(Get) 웹을 검색하는 대신 사이트 데이터에 즉시 액세스할 수 있습니다 .

웹을 검색하는 대신 사이트 데이터에 즉시 액세스할 수 있습니다 맞춤형 웹 크롤링의 구성 및 실행을 용이하게 합니다.

이 응용 프로그램을 사용하여 온라인 추세를 추적 (keep track of online trends) 할 수 있습니다 .

할 수 있습니다 . 원하는 경우 템플릿을 만들 수 있습니다.

더 읽어보기: (Also Read:) Android용 최고의 IP 주소 숨기기 앱 5가지(5 Best IP Address Hider App for Android)

25. 파스허브(25. ParseHub)

ParseHub 는 (ParseHub)AJAX , JavaScript , 쿠키 및 기타 관련 기술 을 사용하는 웹사이트에서 정보를 수집할 수 있는 우수한 웹 크롤러 앱입니다 .

머신 러닝 엔진은 온라인 콘텐츠를 읽고 평가하고 의미 있는 데이터로 변환할 (read, evaluate, and convert online content into meaningful data) 수 있습니다 .

수 있습니다 . 브라우저에 내장된 웹 앱을 사용할 수도 있습니다.

수백만 개의 웹사이트에서 정보를 얻을 수 있습니다.

ParseHub 는 수천 개의 링크와 단어를 자동으로 검색합니다.

는 수천 개의 링크와 단어를 자동으로 검색합니다. 데이터 (Data) 는 당사 서버에 자동으로 수집 및 저장됩니다.

는 당사 서버에 자동으로 수집 및 저장됩니다. 월간 패키지 는 (Monthly packages) $149 부터 시작 합니다.

부터 시작 합니다. 셰어웨어로서 ParseHub에서는 (ParseHub) 5개의 공개 프로젝트만 빌드할 수 있습니다 .

5개의 공개 프로젝트만 빌드할 수 있습니다 . 드롭다운 메뉴 에 액세스하고, 웹 사이트에 로그온하고, 지도를 클릭하고, 무한 스크롤, 탭 및 팝업을 사용하여 웹 페이지를 관리하는 데 사용할 수 있습니다 (access drop-down menus, log on to websites, click on maps, and manage webpages using infinite scroll, tabs, and pop-ups) .

. ParseHub의 데스크톱 클라이언트는 Windows, Mac OS X 및 Linux에서 (Windows, Mac OS X, and Linux) 사용할 수 있습니다 .

사용할 수 있습니다 . 분석을 위해 어떤 형식으로든 스크랩한 데이터를 얻을 수 있습니다.

프리미엄 회원 등급으로 최소 20개의 개인 스크래핑 프로젝트(20 private scraping projects) 를 설정할 수 있습니다 .

추천:(Recommended:)

이 기사가 도움이 되었기를 바라며 좋아하는 무료 웹 크롤러(free web crawler) 도구를 선택하셨기를 바랍니다. 아래 의견 섹션에서 생각, 쿼리 및 제안을 공유하십시오. 또한 누락된 도구를 제안할 수 있습니다. 다음에 배우고 싶은 내용을 알려주세요.

[웹크롤러] 웹 사이트를 빠르게 긁어 모으는 상위 20 웹 크롤링 도구

반응형

웹 크롤링은 오늘날 많은 분야에서 광범위하게 적용되고 있습니다만,

웹 크롤러 도구가 공개되기 전에는 프로그래밍 기술이 없는 사람들에게는 그저 마법의 단어였던 시절도 있었습니다.

현존하는 최고의 웹 크롤러 TOP 20을 소개할까 합니다.

1. Octoparse

https://www.octoparse.com/

귀여운 아이콘으로 혼동하지 마십시오. Octoparse 는 웹 사이트에서 필요한 거의 모든 종류의 데이터를 추출 할 수있는 강력한 웹 사이트 크롤러 입니다.

Octoparse를 사용하여 광범위한 기능을 갖춘 웹 사이트를 리핑 할 수 있습니다. 프로그래머가 아닌 사용자가 빠르게 선택할 수 있도록 마법사 모드와 고급 모드의 두 가지 작동 모드가 있습니다.

사용자 친화적 인 포인트 앤 클릭 인터페이스는 전체 추출 과정을 안내합니다. 결과적으로 웹 사이트 컨텐츠를 쉽게 가져 와서 짧은 시간 내에 Excel, TXT, HTML 또는 데이터베이스 와 같은 구조화 된 형식으로 저장할 수 있습니다 .

또한 예약 된 클라우드 추출 을 제공 하여 동적 데이터를 실시간 으로 추출 하고 웹 사이트 업데이트에 대한 추적 기록을 유지할 수 있습니다.

내장 된 Regex 및 XPath 구성을 사용하여 요소를 정확하게 찾아서 복잡한 구조의 복잡한 웹 사이트를 추출 할 수도 있습니다. 더 이상 IP 차단에 대해 걱정할 필요가 없습니다.

Octoparse는 IP 프록시 서버를 제공하여 IP를 자동화하여 공격적인 웹 사이트에 의해 감지되지 않습니다. 결론적으로 Octoparse는 코딩 기술 없이도 기본 또는 고급 사용자 크롤링 요구를 대부분 충족시킬 수 있어야합니다.

2. Cyotek WebCopy

https://www.cyotek.com/

WebCopy 는 이름과 같은 설명입니다. 오프라인 참조를 위해 부분 또는 전체 웹 사이트를 하드 디스크에 로컬로 복사 할 수있는 무료 웹 사이트 크롤러입니다.

봇에게 크롤링 방법을 알려주도록 설정을 변경할 수 있습니다. 그 외에도 도메인 별칭, 사용자 에이전트 문자열, 기본 문서 등을 구성 할 수도 있습니다.

그러나 WebCopy에는 가상 DOM 또는 모든 형태의 JavaScript 구문 분석이 포함되지 않습니다. 웹 사이트에서 JavaScript를 많이 사용하여 작동하는 경우 WebCopy가 실제 사본을 만들 수 없을 것입니다. JavaScript를 많이 사용하여 동적 웹 사이트 레이아웃을 올바르게 처리하지 못할 가능성이 있습니다.

3. HTTrack

https://www.httrack.com/

웹 사이트 크롤러 프리웨어 인 HTTrack 은 전체 웹 사이트를 PC로 다운로드하는 데 적합한 기능을 제공합니다. Windows, Linux, Sun Solaris 및 기타 Unix 시스템 용 버전이 있으며 대부분의 사용자를 대상으로합니다.

HTTrack이 하나의 사이트 또는 하나 이상의 사이트를 공유 링크와 함께 미러링 할 수 있다는 점이 흥미 롭습니다. “설정 옵션”에서 웹 페이지를 다운로드하는 동안 동시에 열 수있는 연결 수를 결정할 수 있습니다.

미러링 된 웹 사이트에서 사진, 파일 및 HTML 코드를 가져와 중단 된 다운로드를 재개 할 수 있습니다.

또한 HTTTrack 내에서 프록시 지원을 통해 속도를 극대화 할 수 있습니다.

HTTrack은 명령 줄 프로그램 또는 개인 (캡처) 또는 전문 (온라인 웹 미러) 사용을위한 셸을 통해 작동합니다. HTTrack은 고급 프로그래밍 기술을 가진 사람들이 선호하고 더 많이 사용해야합니다.

4. Getleft

https://sourceforge.net/projects/getleftdown/

Getleft 는 무료이며 사용하기 쉬운 웹 사이트 그래버입니다. 전체 웹 사이트 또는 단일 웹 페이지를 다운로드 할 수 있습니다. Getleft를 시작한 후 URL을 입력하고 시작하기 전에 다운로드 할 파일을 선택할 수 있습니다.

진행되는 동안 로컬 브라우징을위한 모든 링크가 변경됩니다. 또한 다국어 지원을 제공합니다. 이제 Getleft는 14 개 언어를 지원합니다! 그러나 제한된 FTP 지원 만 제공하며 파일을 다운로드하지만 재귀 적으로 다운로드하지는 않습니다.

Getleft는 더 복잡한 전술 기술없이 사용자의 기본 크롤링 요구를 충족시켜야합니다.

5. Scraper

Scraper는 데이터 추출 기능이 제한적인 Chrome 확장 프로그램이지만 온라인 조사에 도움이됩니다. 또한 데이터를 Google 스프레드 시트로 내보낼 수 있습니다.

이 도구는 초보자와 전문가를위한 것입니다. OAuth를 사용하여 데이터를 클립 보드에 쉽게 복사하거나 스프레드 시트에 저장할 수 있습니다. 스크레이퍼는 크롤링 할 URL을 정의하기 위해 XPath를 자동 생성 할 수 있습니다.

포괄적 인 크롤링 서비스를 제공하지는 않지만 대부분의 사람들은 어수선한 구성을 처리 할 필요가 없습니다.

6. OutWit Hub

https://www.scrapestorm.com/

OutWit Hub는 웹 검색을 단순화하기 위해 수십 가지 데이터 추출 기능이있는 Firefox 애드온입니다. 이 웹 크롤러 도구는 페이지를 탐색하고 추출 된 정보를 적절한 형식으로 저장할 수 있습니다.

OutWit Hub는 필요에 따라 소량 또는 대량의 데이터를 스크랩하기위한 단일 인터페이스를 제공합니다. 브라우저 자체에서 웹 페이지를 긁을 수 있습니다. 자동 에이전트를 만들어 데이터를 추출 할 수도 있습니다.

가장 간단한 웹 스크래핑 도구 중 하나이며 무료로 사용할 수 있으며 한 줄의 코드를 작성하지 않고도 웹 데이터를 편리하게 추출 할 수 있습니다.

7. ParseHub

https://www.parsehub.com/

ParseHub 는 AJAX 기술, JavaScript, 쿠키 등을 사용하는 웹 사이트에서 데이터 수집을 지원하는 훌륭한 웹 크롤러입니다. 머신 러닝 기술은 웹 문서를 읽고 분석하고 관련 데이터로 변환 할 수 있습니다.

ParseHub의 데스크탑 응용 프로그램은 Windows, Mac OS X 및 Linux와 같은 시스템을 지원합니다. 브라우저 내에 내장 된 웹 앱을 사용할 수도 있습니다.

프리웨어로서 ParseHub에서 최대 5 개의 공개 프로젝트를 설정할 수 있습니다. 유료 가입 플랜을 사용하면 웹 사이트 스크랩을위한 최소 20 개의 개인 프로젝트를 만들 수 있습니다.

ParseHub 사용방법 <= 더보기 8. VisualScraper http://visualscraper.blogspot.com/ VisualScraper 는 간단한 포인트 앤 클릭 인터페이스를 갖춘 또 하나의 훌륭한 무료 비 코딩 웹 스크레이퍼입니다. 여러 웹 페이지에서 실시간 데이터를 가져와 추출 된 데이터를 CSV, XML, JSON 또는 SQL 파일로 내보낼 수 있습니다. SaaS 외에도 VisualScraper는 데이터 전송 서비스 및 소프트웨어 추출기 서비스 생성과 같은 웹 스크랩 서비스를 제공합니다. VisualScraper를 사용하면 특정 시간에 프로젝트가 실행되도록 예약하거나 매분, 일, 주, 월 또는 년마다 시퀀스를 반복 할 수 있습니다. 사용자는이를 사용하여 뉴스, 업데이트 또는 포럼을 자주 추출 할 수 있습니다. 9. Scrapinghub https://www.scrapinghub.com/ Scrapinghub 는 수천 명의 개발자가 귀중한 데이터를 가져 오는 데 도움이되는 클라우드 기반 데이터 추출 도구입니다. 오픈 소스 비주얼 스크래핑 도구를 사용하면 프로그래밍 지식없이 웹 사이트를 스크랩 할 수 있습니다. Scrapinghub는 봇 대응책 우회를 지원하여 거대하거나 봇으로 보호 된 사이트를 쉽게 크롤링하는 스마트 프록시 로테이터 인 Crawlera를 사용 합니다. 사용자는 간단한 HTTP API를 통해 프록시 관리의 어려움없이 여러 IP 및 위치에서 크롤링 할 수 있습니다. Scrapinghub는 전체 웹 페이지를 체계화 된 콘텐츠로 변환합니다. 크롤링 빌더가 요구 사항에 맞지 않을 경우 전문가 팀에서 도움을받을 수 있습니다. 10. Dexi.io https://www.dexi.io/ 브라우저 기반 웹 크롤러 인 Dexi.io를 사용하면 모든 웹 사이트에서 브라우저를 기반으로 데이터를 긁어 낼 수 있으며 추출기, 크롤러 및 파이프와 같은 긁기 작업을 생성 할 수있는 세 가지 유형의 로봇을 제공 할 수 있습니다. 프리웨어는 웹 스크래핑을위한 익명의 웹 프록시 서버를 제공하며 추출 된 데이터는 데이터가 보관되기 전에 2 주 동안 Dexi.io 서버에서 호스팅되거나 추출 된 데이터를 JSON 또는 CSV 파일 로 직접 내보낼 수 있습니다 . 실시간 데이터를 얻는 데 필요한 유료 서비스를 제공합니다. 11. Webhose.io https://webhose.io/ Webhose.io를 사용 하면 전 세계의 온라인 소스를 크롤링하여 다양한 형식으로 실시간 데이터 를 얻을 수 있습니다. 이 웹 크롤러를 사용하면 다양한 소스를 포괄하는 여러 필터를 사용하여 데이터를 크롤링하고 다양한 언어로 키워드를 추가로 추출 할 수 있습니다. 또한 스크랩 된 데이터를 XML, JSON 및 RSS 형식으로 저장할 수 있습니다. 사용자는 보관소에서 기록 데이터에 액세스 할 수 있습니다. 또한 webhose.io는 크롤링 데이터 결과로 최대 80 개 언어를 지원합니다. 사용자는 Webhose.io에서 크롤링 한 구조화 된 데이터를 쉽게 색인화하고 검색 할 수 있습니다. 사용자의 기본 크롤링 요구 사항을 충족 할 수 있습니다. 사용자는 특정 웹 페이지에서 데이터를 가져오고 CSV로 데이터를 내 보내서 자체 데이터 세트를 구성 할 수 있습니다. 반응형 12. Import.io http://import.io/ 한 줄의 코드를 작성하지 않고도 몇 분 만에 수천 개의 웹 페이지를 쉽게 긁을 수 있으며 요구 사항에 따라 1000 개 이상의 API를 작성할 수 있습니다. 공개 API는 프로그래밍 방식으로 Import.io 를 제어 하고 자동으로 데이터에 액세스 할 수있는 강력하고 유연한 기능을 제공했습니다 . Import.io는 몇 번의 클릭만으로 웹 데이터를 자신의 앱 또는 웹 사이트에 통합함으로써 크롤링을 더 쉽게 만들었습니다. 또한 사용자의 크롤링 요구 사항을보다 효과적으로 충족시키기 위해 Windows, Mac OS X 및 Linux 용 무료 앱을 제공하여 데이터 추출기 및 크롤러를 구축하고 데이터를 다운로드하며 온라인 계정과 동기화합니다. 또한 사용자는 매주, 매일 또는 매시간 크롤링 작업을 예약 할 수 있습니다. 13. 80legs https://80legs.com/ 80legs 는 사용자 지정 요구 사항에 따라 구성 할 수있는 강력한 웹 크롤링 도구입니다. 추출 된 데이터를 즉시 다운로드 할 수있는 옵션과 함께 대량의 데이터 가져 오기를 지원합니다. 80legs는 빠르게 작동하고 필요한 데이터를 단 몇 초 만에 가져 오는 고성능 웹 크롤링을 제공합니다. 14. Spinn3r http://docs.spinn3r.com/ Spinn3r을 사용하면 블로그, 뉴스, 소셜 미디어 사이트, RSS 피드 및 ATOM 피드에서 전체 데이터를 가져올 수 있습니다. Spinn3r은 색인 작업의 95 %를 관리하는 firehouse API와 함께 배포됩니다. 고급 스팸 방지 기능을 제공하여 스팸 및 부적절한 언어 사용을 제거하여 데이터 안전성을 향상시킵니다. Spinn3r은 Google과 유사하게 컨텐츠를 색인화하고 추출 된 데이터를 JSON 파일로 저장합니다. 웹 스크레이퍼는 지속적으로 웹을 검색하고 여러 소스에서 업데이트를 찾아 실시간으로 발행합니다. 관리 콘솔을 사용하면 크롤링 및 전체 텍스트 검색을 제어하여 원시 데이터에 대한 복잡한 쿼리를 수행 할 수 있습니다. 15. Content Grabber https://contentgrabber.com/ Content Grabber 는 기업을 대상으로하는 웹 크롤링 소프트웨어입니다. 독립형 웹 크롤링 에이전트를 작성할 수 있습니다. 거의 모든 웹 사이트에서 컨텐츠를 추출하여 Excel 보고서, XML, CSV 및 대부분의 데이터베이스를 포함하여 원하는 형식으로 구조화 된 데이터로 저장할 수 있습니다. 필요로하는 사람들을 위해 강력한 스크립팅, 편집 및 디버깅 인터페이스를 제공하기 때문에 고급 프로그래밍 기술을 가진 사람들에게 더 적합합니다. 사용자는 C # 또는 VB.NET을 사용하여 크롤링 프로세스 프로그래밍을 제어하는 스크립트를 디버깅하거나 작성할 수 있습니다. 예를 들어 Content Grabber는 Visual Studio 2013 과 통합되어 사용자의 특정 요구에 따라 고급의 효율적인 사용자 정의 크롤러에 대한 가장 강력한 스크립트 편집, 디버깅 및 단위 테스트를 수행 할 수 있습니다. 16. Helium Scraper https://www.heliumscraper.com/ Helium Scraper 는 시각적 웹 데이터 크롤링 소프트웨어로 요소 간 연결이 적을 때 잘 작동합니다. 비 코딩 및 비 구성입니다. 또한 사용자는 다양한 크롤링 요구에 따라 온라인 템플릿에 액세스 할 수 있습니다. 기본적으로 기본 수준 내에서 사용자의 크롤링 요구를 충족시킬 수 있습니다. 17. UiPath https://www.uipath.com/ UiPath 는 무료 웹 스크래핑을위한 로봇 프로세스 자동화 소프트웨어입니다. 대부분의 타사 앱에 대한 웹 및 데스크톱 데이터 크롤링을 자동화합니다. 로봇 프로세스 자동화 소프트웨어를 Windows에서 실행하면 설치할 수 있습니다. UiPath는 여러 웹 페이지에서 테이블 형식 및 패턴 기반 데이터를 추출 할 수 있습니다. UiPath는 추가 크롤링을위한 기본 제공 도구를 제공했습니다. 이 방법은 복잡한 UI를 처리 할 때 매우 효과적입니다. 화면 스크래핑 도구는 개별 텍스트 요소, 텍스트 그룹 및 텍스트 블록 (예 : 테이블 형식의 데이터 추출)을 모두 처리 할 수 있습니다. 또한 지능형 웹 에이전트를 만드는 데 프로그래밍이 필요하지 않지만 내부의 .NET 해커는 데이터를 완전히 제어 할 수 있습니다. 18. Scrape.it https://scrape.it/ Scrape.it 는 Node.js 웹 스크랩 핑 소프트웨어입니다. 클라우드 기반 웹 데이터 추출 도구입니다. 전 세계 수백만 개발자와 코드를 발견, 재사용, 업데이트 및 공유 할 수있는 공개 및 개인 패키지를 모두 제공하므로 고급 프로그래밍 기술을 갖춘 사용자를 위해 설계되었습니다. 강력한 통합 기능을 통해 필요에 따라 맞춤형 크롤러를 구축 할 수 있습니다. 19. WebHarvy https://www.webharvy.com/ WebHarvy 는 포인트 앤 클릭 방식의 웹 스크래핑 소프트웨어입니다. 프로그래머가 아닌 사용자를 위해 설계되었습니다. WebHarvy는 웹 사이트에서 텍스트, 이미지, URL 및 이메일을 자동으로 스크랩하고 스크랩 된 컨텐츠를 다양한 형식으로 저장할 수 있습니다. 또한 익명으로 크롤링하고 웹 스크랩 소프트웨어가 웹 서버에 의해 차단되는 것을 방지하는 내장 스케줄러 및 프록시 지원을 제공합니다. 프록시 서버 또는 VPN을 통해 대상 웹 사이트에 액세스 할 수 있습니다. 사용자는 웹 페이지에서 추출한 데이터를 다양한 형식으로 저장할 수 있습니다. WebHarvy 웹 스크레이퍼의 현재 버전을 사용하면 스크랩 된 데이터를 XML, CSV, JSON 또는 TSV 파일로 내보낼 수 있습니다. 사용자는 스크랩 된 데이터를 SQL 데이터베이스로 내보낼 수도 있습니다. 20. Connotate https://commoncrawl.org/ Connotate 는 엔터프라이즈 규모의 솔루션 이 필요한 엔터프라이즈 규모의 웹 컨텐츠 추출을 위해 설계된 자동 웹 크롤러입니다 . 비즈니스 사용자는 프로그래밍없이 몇 분만에 추출 에이전트를 쉽게 만들 수 있습니다. 사용자는 포인트 앤 클릭만으로 추출 에이전트를 생성 할 수 있습니다. Ajax와 같은 복잡한 JavaScript 기반 동적 사이트 기술을 포함하여 프로그래밍없이 사이트의 95 % 이상을 자동으로 추출 할 수 있습니다. Connotate는 대부분의 사이트에서 데이터를 크롤링하기위한 모든 언어를 지원합니다. 또한 Connotate는 데이터베이스 추출을 위해 SQL 데이터베이스 및 MongoDB의 컨텐츠를 포함하여 웹 페이지 및 데이터베이스 컨텐츠를 통합하는 기능도 제공합니다. 이 글이 조금이나마 도움이 되셨다면 , 공감! 댓글! 부탁드립니다. ^^ 오늘도 행복한 하루 되세요~♡!! 반응형

So you have finished reading the 크롤링 프로그램 topic article, if you find this article useful, please share it. Thank you very much. See more: 파이썬 크롤링 프로그램, 무료 크롤링 프로그램, 크롤링 프로그램 만들기, 네이버 블로그 크롤링 프로그램, 이미지 크롤링 프로그램, 쇼핑몰 크롤링 프로그램, Octoparse 사용법, 크롤링 확장프로그램